El 2016 cerró con un intenso debate sobre la caída en el rendimiento en la Prueba de Selección Universitaria (PSU) de los llamados liceos emblemáticos: aquellos que hasta ahora seleccionan entre los mejores alumnos. En esta columna, el académico del Centro de Investigación de la Complejidad Social de la UDD Jorge Fábrega analiza los datos disponibles y concluye que no existen evidencias de que el desempeño de esos liceos se haya desplomado. De paso, alerta sobre el peligro de que las políticas públicas sean influenciadas por datos incompletos pero que generan alarma en la ciudadanía.

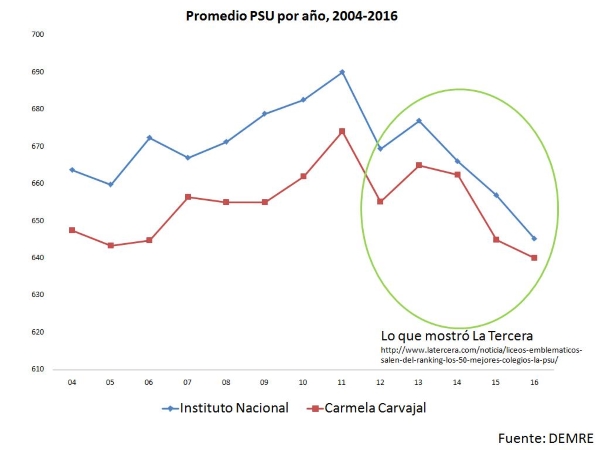

El 26 de diciembre pasado se publicó en La Tercera una noticia sobre la caída de puntajes de liceos emblemáticos que iluminó el ocaso del 2016 como si fueran fuegos artificiales. El dato que mostraba el diario era visualmente claro y fácil de interpretar. En él se veía claramente una caída sistemática de los promedios de la PSU de dos liceos emblemáticos (Instituto Nacional y Carmela Carvajal) desde el 2013 al 2016 y un texto que contaba que esos establecimientos ya no estaban en el top 50 del país. Ardió Troya.

Varios parlamentarios y líderes políticos salieron rápidamente a culpar por estos resultados al fin de la selección que impulsa el actual gobierno (ejemplo 1, ejemplo 2). Otros culparon a las movilizaciones y paros iniciados el 2011. Algunos académicos escribieron columnas, otros las retuitearon por redes sociales. Figuras de Evopoli y Revolución Democrática se dijeron de todo por Twitter. En fin, todo muy parafernálico. Un buen espectáculo de luces, se podría decir.

El problema que veo en todo este debate es que el dato que lo originó no permite deducir nada. Y lo que me incomoda es que muchos que han criticado las desprolijidades del Ministerio de Educación en llevar adelante sus reformas (¡que vaya que las ha habido!), están por estos días haciendo exactamente lo mismo que critican.

De todos modos, algo sí se puede decir sin más datos que los de la nota en La Tercera. Por ejemplo, claramente lo sucedido no puede ser causado por el fin de la selección simplemente porque ésta aún no se produce y faltan aún varios años para ello. Por otro lado, sí parece razonable hipotetizar que las movilizaciones y paros hayan tenido efectos negativos en los puntajes. O sea, ésa es la más inocente de las hipótesis que podríamos hacer. Mal que mal, ir a clases y estudiar debería incidir en el desempeño de la PSU. De lo contrario, si no tuviera efectos, estaríamos ante problemas más serios aún porque querría decir que faltar durante 13 meses a clases (como dijo el rector del Instituto Nacional que sucedió con los egresados de su plantel este año) no incide en nada. Pero el dato del promedio de un establecimiento año tras año no es evidencia suficiente para convencernos de que estamos viendo realmente el efecto de las movilizaciones.

Intrigado por el tema, aproveché las horas finales del 2016 para buscar datos en internet de la PSU que me ayudaran a entender. Lo primero que hice fue completar la serie que publicó La Tercera hasta el inicio de la PSU el 2004 ¿Qué esperaba encontrar? Quería ver si los promedios se mantenían estables en el tiempo y abruptamente empezaban a caer el 2013. No obtuve eso. De hecho el dato no me sirvió para aclarar nada: los promedios PSU del Instituto Nacional y el Carmela Carvajal suben hasta el 2011 y luego con vaivenes caen. El resultado lo puse en el gráfico 1 y lo compartí en redes sociales. El tweet rápidamente se viralizó y recibí todo tipo de comentarios. Lo más sorprendente es que muchas reacciones fueron del tipo “esto confirma que las movilizaciones causaron la caída de los emblemáticos” o “esto demuestra que la culpa la tuvo el gobierno de Piñera”. Definitivamente, la gente ve en los datos lo que quiere ver.

Gráfico 1

Sólo a modo de divertimento, déjenme agregar otra posible explicación de la serie. Aquí vamos: Los liceos emblemáticos (porque son muy buenos) aprendieron más rápido las tácticas para responder eficazmente las preguntas del nuevo sistema PSU introducido el 2004 y esa ventaja les permitió subir su promedio en los primeros años de la prueba. Pero luego otros establecimientos también aprendieron y los alcanzaron. La PSU se volvió más competitiva (y, por ende, empezaron a bajar en términos relativos) y sus puntajes de ahora son más cercanos a su verdadero nivel esperado. Acéptenme que, al menos, es una hipótesis algo más sofisticada ¿o no? Pero, NO NO NO. No me crea. Por ningún motivo interprete los datos como yo (mal) intencionadamente acabo de hacer.

Aún cuando pueda ser plausible “mi” hipótesis, la serie de datos de promedios de la PSU NO ME PERMITE deducir la explicación que les acabo de dar. La razón es simple: Cada año, los puntajes que alguien saca en la PSU son relativos a las personas que rindieron la prueba ese mismo año. No es una nota absoluta y, por ende, tu puntaje no es directamente comparable con el de otra persona en otro año. Es decir, si tu liceo o colegio promedió 600 puntos un año y al año siguiente obtuvo 610: ¡no aceptes el mensaje del rector del establecimiento diciendo que les fue 10 puntos mejor este año! Eso es incorrecto.

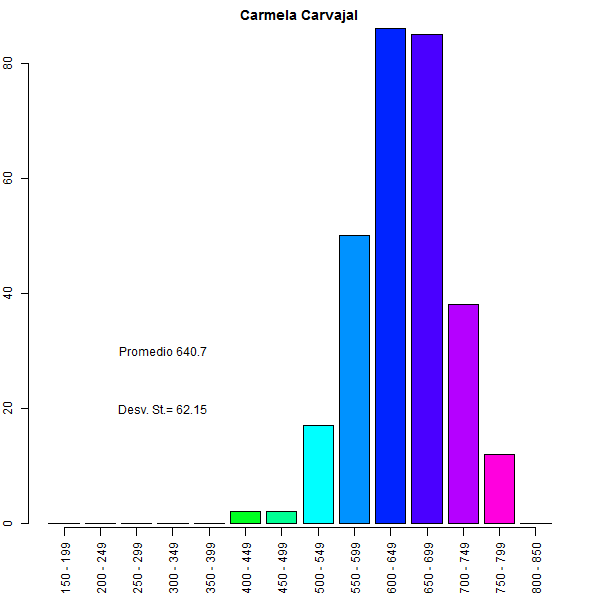

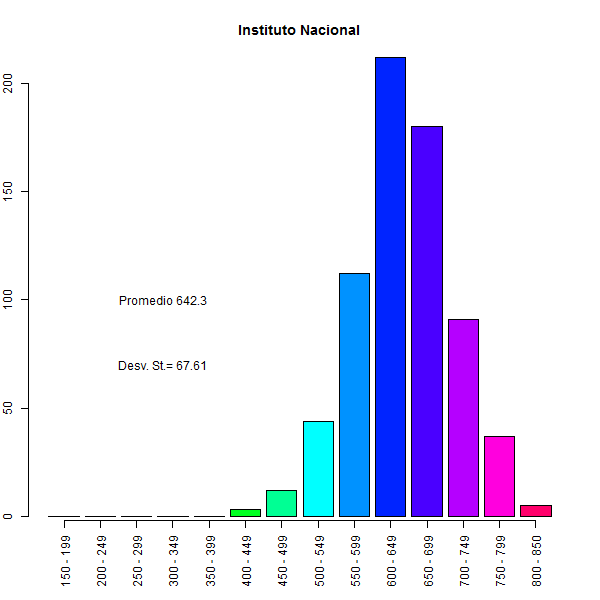

Además, aún cuando fuese posible comparar entre períodos, no basta el promedio. Por ejemplo, un liceo donde la mitad de los estudiantes obtienen 500 puntos y la otra mitad logra 700 puntos tiene el mismo promedio que otro liceo donde todos obtienen 600 puntos, pero claramente son dos establecimientos con realidades diferentes. Por eso también importa la dispersión de puntajes dentro de cada establecimiento: si la variación es elevada, el promedio informa muy poco. Y éste es precisamente el caso de los liceos emblemáticos que seleccionó La Tercera.

Vean los gráficos 2 y 3: En la PSU 2016, el liceo Carmela Carvajal obtuvo una media de 640,7 y una desviación estándar de 62,15; por su parte, el Instituto Nacional obtuvo 642,3 promedio y su desviación estándar fue de 67,61. Si esas dispersiones del 2016 entre estudiantes dentro del Instituto Nacional y entre estudiantes dentro del liceo Carmela Carvajal no son diametralmente distintas a las de egresados de esos establecimientos en años anteriores (no hay razones para pensar que lo sean), los datos no nos permiten hablar de caída de los emblemáticos porque la brecha de puntajes promedio es muy pequeña en relación a la dispersión de las notas.

Gráfico 2: Distribución de los Puntajes PSU en el Liceo Carmela Carvajal (Fuente: DEMRE)

Gráfico 3: Distribución de los Puntajes PSU en el Instituto Nacional (Fuente: DEMRE)

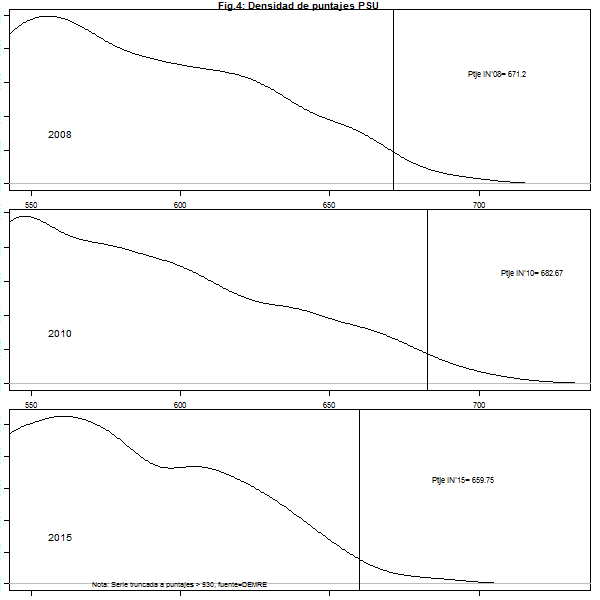

Lo anterior no quiere decir que sea completamente infructuoso hacer el ejercicio que hizo La Tercera (y que yo completé hasta el 2004) porque la normalización que se hace todos los años no es arbitraria. Si pudiésemos conocer la dispersión de cada año algo aún podemos hacer con los promedios por colegios para entender lo que estaría pasando con los emblemáticos. De acuerdo a Antivilo, Contreras y Hernández (2015) (*1), los puntajes de la PSU son ajustados para que tengan una distribución con media 500 y desviación 110. Ello implica, por ejemplo, que las personas que obtienen sobre 720 puntos están en el 2% superior y los que obtienen sobre 610 puntos están en el 14% superior, aproximadamente. Esos porcentajes variarán de año a año pero en proporciones insignificantes para políticas públicas. Por ende, podemos hacer un ejercicio más completo que la simple comparación de puntajes promedios año a año. Específicamente, podemos ver cómo se ubica un establecimiento (en promedio) respecto del conjunto de establecimiento para cada año. Si de ese ejercicio constatamos que sistemática y significativamente un establecimiento va cayendo en la distribución año a año, entonces, sí estamos ante un dato consistente con las hipótesis de desplome que algunos han sugerido.

Lamentablemente, no pude encontrar el listado completo de puntajes promedios, pero sí encontré la información de los puntajes promedios por establecimientos que promediaron sobre 530 puntos cada año desde el 2005 al 2015. No es lo ideal, pero al menos sí nos permite mirar el desempeño relativo del Instituto Nacional y del liceo Carmela Carvajal en cada cohorte ¿Y qué encontré? El gráfico 4 muestra las densidades de las distribuciones de las PSU para tres años de la muestra. En ellos se destaca el puntaje del Instituto Nacional con una línea vertical (671,2 el 2008, 682,67 el 2010 y 659,75 el 2015). A la derecha de cada línea vertical están representados los colegios que obtuvieron mejores puntajes promedio que el Instituto Nacional. Como puede verse a simple vista, el promedio PSU del Instituto Nacional varió entre estos años, pero las áreas a su derecha son similares.

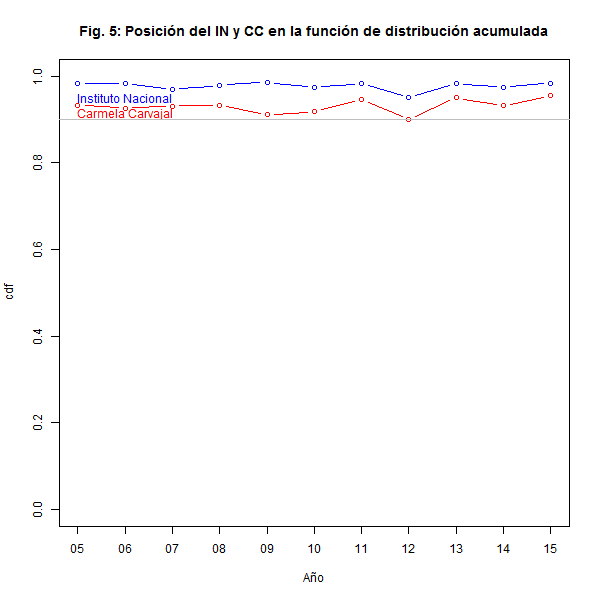

¿Será distinto para otros años? De acuerdo a mi revisión de los datos, no. Para tener una idea más precisa, calculé la densidad acumulada de la distribución de puntajes cada año. Esta métrica permite decir qué proporción del total de establecimientos se encuentran por sobre o por debajo de un puntaje determinado. Por ejemplo, para el establecimiento con mejor promedio un año, todo el resto estuvo por debajo; para el que está en el percentil 90, la proporción por debajo suyo es 0.9, etc. El gráfico 5 resume esta información para el Instituto Nacional y el liceo Carmela Carvajal. Al igual que en el gráfico 4, caídas sistemática en el desempeño promedio de un establecimiento se deberían reflejar en que la proporción por debajo de este cae sistemáticamente. En el eje vertical de la figura 5 aparece la distribución acumulada y la línea horizontal de color gris corta en la proporción 0.9. Es decir, debajo de la línea está acumulado el equivalente al 90% de los colegios y sobre la línea el 10% restante de la muestra. OJO: recuérdese que sólo tengo datos de los establecimientos con puntajes promedio sobre 530 puntos. Por ende, el desempeño de los establecimientos analizados es en realidad mucho mejor de lo que muestran los gráficos. Pero ¿qué muestran?

El gráfico 5 sugiere que sistemáticamente el Instituto Nacional y el liceo Carmela Carvajal han estado entre los mejores (al menos) 10% establecimientos educacionales del país y eso no ha variado en años recientes ¿qué significa eso? para decirlo en versión tweet: No hay evidencia de desplome alguno en el desempeño del Instituto Nacional y el Carmela Carvajal en años recientes. 114 caracteres.

Para ir cerrando esta nota: Este breve análisis no debe tomarse como definitivo. Por ejemplo, no he revisado el desempeño anual de establecimientos con o sin tomas. No he considerado el número de estudiantes de cada establecimiento. Tampoco me he detenido a analizar los eventuales comportamientos estratégicos que generó el cambio de ponderación en los rankings de notas. Y, por mencionar sólo otra limitación, tampoco tengo el panorama completo de cada año porque sólo pude analizar la cola superior de la distribución (sobre 530 puntos, vuelvo a insistir). Pero, pese a todas esas limitaciones, los datos no parecen mostrar nada que justifique el escándalo que se ha producido tras los resultados de la PSU del 2016.

En todo caso, yo aún esperaría encontrar algún tipo de efecto de las movilizaciones, pero al menos en estos datos no se observan; y si estuvieran, encontrarlos requerirá de análisis más detallados.

Pero ¿para qué detenerse a hacer estos análisis? La verdad es que me incomoda ver cómo parlamentarios y académicos, que entre sus méritos incluyen doctorados en prestigiosas universidades a nivel mundial, sean los primeros en la fila de las alarmas. Tampoco se ve bien que el gobierno se preste a revisar sus políticas de admisión a la educación superior sin poner la pausa a entender qué nos enseña el dato. Algo no anda bien cuando eso te torna hábito y no nos asombra. Por el afán de salir a golpear con una noticia, de mover sin el mínimo pudor las agendas propias, por el deseo de lograr más likes, o por la razón que sea, estamos dejando que las agendas en políticas públicas se desarrollen a partir de gráficos en los medios que no han pasado por una mínima dosis de escepticismo y crítica. Creo que podemos hacerlo mejor.

Jorge Fábrega es economista y sociólogo (PUC), doctor en Políticas Públicas (U de Chicago). Académico en el Centro de Investigación de la Complejidad Social de la Universidad del Desarrollo.

Referencias:

(*1) A. Antivilo ; P. Contreras y J. Hernández (2015): Tratamiento de Puntajes. Unidad de Estudios e Investigación. Departamento de Evaluación, Medición y Registro Educacional (DEMRE). Universidad de Chile.

«Los puntajes son relativos a las personas que rindieron la prueba ese mismo año. No es una nota absoluta y, por ende, tu puntaje no es directamente comparable con el de otra persona en otro año. »

Ese método estadístico es muy malo. Serìa mucho mejor que los puntajes fueran absolutos, para poder comparar niveles de años distintos.