En la última semana de noviembre, el gobierno lanzó una “ofensiva” para destacar los logros educativos del período. Algunos lo interpretaron como una cobertura por los malos datos que sabían que venían en las pruebas PISA. En particular, al comentar los datos del Anuario Estadístico de Educación, las principales autoridades destacaron mayores ingresos a la carrera docente y un mayor número de egresos de la misma. También se destacó una reducción de 1 punto porcentual en la repetición de ciclo básico.

Muchos analistas criticaron esta actitud por varias razones. En primer lugar, algunas de las mejorías son muy pequeñas en relación a la magnitud del problema (la repetición y el abandono son escandalosos, y una mejoría de un punto porcentual es muy pequeña). En segundo lugar, las cifras de repetición no significan nada en sí mismas: se pueden bajar con medidas como el “pase social” que mejoró las cifras de repetición en primaria, y que muchos culpan del abandono y repetición masivos en primero de liceo. Finalmente, si la ofensiva del gobierno era porque sabían que las cifras de PISA iban a dar peor que en la última medición, las mejoras en las cifras que apuntaba el gobierno no estaban teniendo ningún efecto sobre lo que realmente importa, que es la calidad de la educación que reciben los alumnos. En particular, los mayores egresos en magisterio (que no son de este año) podían utilizarse para atender a los más rezagados, y así mejorar los resultados educativos.

Los resultados divulgados esta semana demostraron que, sea lo que sea que el gobierno está haciendo para mejorar la educación, no está resultando: lo que aprenden los alumnos es cada vez menos, y es aún peor cuando se compara con lo que están haciendo otros países.

Por supuesto ampliar la educación a más gente es importante. Y también es relevante que se amplíe la cobertura para niños de 3 y 4 años para que las madres puedan trabajar, y para que ojalá eso tenga algún efecto en el aprendizaje de esos niños. Pero lo que es alarmante, aunque quizás no sea sorprendente con la performance del Ministro de Educación Ehrlich en la Intendencia de Montevideo a la vista, es que cuando se divulgaron los resultados PISA anteriores, según reportó el País el 31 de enero del 2011,

“La educación fue el principal tema en el Consejo de Ministros de hoy. Durante la conferencia de prensa posterior a la reunión del Ejecutivo el titular de Educación, Ricardo Ehrlich dijo que «genera preocupación en todos los ámbitos» los resultados de la prueba Pisa. Y agregó y «el tema entró en la agenda con mucha fuerza».”

Hoy quiero argumentar que, junto con la cobertura de un sistema educativo, la estadística principal es el resultado de la prueba PISA como medida de habilidades. Por supuesto la cobertura (digamos, cuántos chicos terminan liceo) es importante por un tema de equidad: probablemente los adolescentes de ingresos más altos terminen liceo, y que haya una mayor cobertura indica que gente de menores ingresos también está accediendo a la educación (es imperfecto como indicador, porque la calidad seguramente sea dispar, pero en principio, mayor cobertura es mejor).

Además de su importancia como indicador de equidad, también se le solía dar una importancia enorme a esa cifra como indicador del “nivel” de educación de un país: cuantos más años de educación tenía una población, se estimaba que mayor era su “capital humano”. Desde el trabajo de Robert Barro en 1991 “Economic Growth in a Cross Section of Countries” ha habido cientos de trabajos que para explicar el crecimiento económico de un país ponen como determinante su capital humano, medido como “años de educación promedio de la población”. Más aún, el estatus de los años de educación como medida de capital humano se afianzó aún más con los centenares de “ecuaciones de Mincer” que se estimaron en el mundo, explicando el nivel salarial de una persona como función de sus años de estudio. En particular, tanto en las regresiones de crecimiento, como en las estimaciones salariales, los años de educación aparecen como un factor significativo en la explicación.

Recientemente, sin embargo, Eric Hanushek de Stanford (visitó la Universidad de Montevideo el año pasado) comenzó a incluir los resultados académicos de los distintos países (medidos por distintas pruebas estandarizadas) en las regresiones de crecimiento y “demostró” que en realidad los años de estudio no importan para el capital humano, una vez que se incluye cuánto aprenden los alumnos.

Concretamente, las regresiones anteriores decían que había una relación estadísticamente significativa entre los años de estudio de la población, y el crecimiento. Hanushek incluyó los resultados de las pruebas PISA, y mostró que los resultados tenían una relación estadísticamente significativa con el crecimiento económico de los países, y que al incluir los resultados PISA, los años de escolaridad ya no eran un factor estadísticamente significativo en la explicación del crecimiento.

La explicación del autor es que no importa si estás agregando años de estudio a la población, si eso no se traduce en mejores aprendizajes. Para el crecimiento lo que importa es el aprendizaje, y no los años de educación. En un extremo, un país que aumenta sus años de educación, pero empeora las pruebas PISA tenderá a crecer menos.

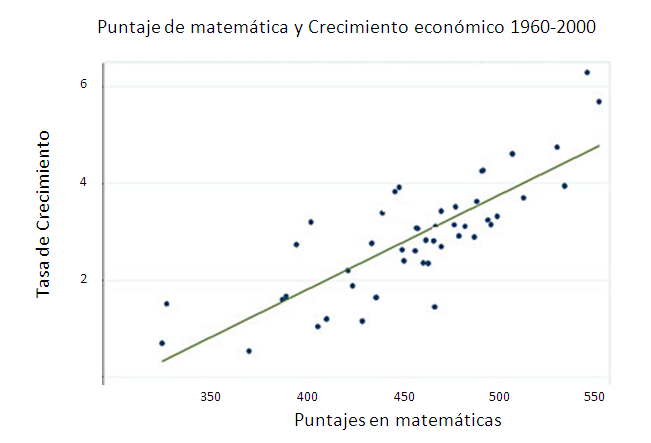

Sólo para ilustrar gráficamente, en la imagen (tomada de un artículo de Peterson y Hanushek) vemos los puntajes en pruebas estándar de matemática para distintos países en el eje horizontal, y su tasa de crecimiento en el vertical (ambas medidas entre 1960 y 2000).

La siguiente tabla muestra los efectos de distintas variables sobre el crecimiento económico de 50 países entre 1960 y 2000. Cada coeficiente nos dice en cuánto aumenta el crecimiento económico de un país, si se aumenta en una unidad la variable que aparece en ese renglón. Una estrella al lado de un coeficiente indica que la variable es estadísticamente significativa para explicar el crecimiento; si no hay estrella es que la variable no es significativa.

En la primera columna se ve que si no se incluye a las habilidades cognitivas (medidas como puntajes en pruebas estandarizadas como PISA), los años de escolaridad importan para determinar el crecimiento, y que se explica 25% de la variación en las tasas de crecimiento de los países (se incluye también el PBI per cápita de los países, pues si un país era pobre en 1960, es más probable que crezca rápido en los años siguientes). En la segunda columna se incluye a las habilidades cognitivas, y dejan de importar los años de escolaridad; a su vez se logra explicar un 73% de la variación de tasas de crecimiento entre países.

Crecimiento económico ‘60-2000 y educación

| (1) | (2) | |

| Habilidades cognitivas | 1,98* | |

| Años de escolaridad en 1960 | 0,369* | 0,026 |

| PBI per cápita en 1960 | -0,38* | -0,3* |

| % de variación explicada | 25% | 72,8% |

Fuente: Hanushek 2013.

Quizás todo lo anterior sea demasiado para una columna en un diario. Pero el punto es que no debería interesarnos casi nada de lo que diga Ehrlich que no esté relacionado con mejorar los aprendizajes y los resultados de las pruebas PISA. Lo triste es que hace tres años el tema entró con mucha fuerza en la agenda, y aún así empeoraron los resultados.

Eric Hanushek “Economic growth in developing countries: The role of human capital,” Economics of Education Review, 37, 2013.

No leí el paper pero cualquier argumento de que el presente influye sobre el pasado insinúa la posibilidad de causalidad inversa.

Hola Eduardo. El argumento no es así (de presente influye pasado), quizás no está claro en la nota. De todas maneras Hanushek hace todo tipo de controles para contrarrestar ese argumento (por ejemplo: incrementos entre t y t+1 de puntaje pisa, contra incremento en crecimiento entre t+1 y t+2, y cosas del estilo).

Saludos

Perdón, entendí que el gráfico intentaba explicar el crecimiento 1960-2000 con resultados de pruebas PISA que son relativamente más recientes.

Estimado Juan,

En relación al empeoramiento de Uruguay en los resultados de las pruebas PISA, ¿ves viable un análisis empírico de este empeoramiento, con técnicas de descomposición (Oaxaca Blinder, RIF Regression, etc). El objetivo sería explicar ese empeoramiento entre la primera y última prueba PISA, evaluando si han cambiado las características de los alumnos, su entorno, su institución.

Saludos!

Joaquín

Hola Joaquín, gracias por el comentario. Creo que no entendemos la educación suficientemente bien como para saber qué es lo que llevó al empeoramiento, con lo cual no sé mucho qué variables se podrían incluir para explicar la caída (y que la creyéramos).

Además tampoco tenés una cantidad importante de información que puede tener que ver (por ejemplo: calidad de los maestros; calidad de la gente que entra a magisterio, etc).

En principio es una buena idea, pero me parece que en cualquier caso nos falta información.

Te mando un saludo cordial

juan